2016年是人工智能发展历程中一个具有里程碑意义的年份。这一年,基础软件开发取得了显著进展,不仅推动了AI技术的普及与应用,也为后续的爆发式增长奠定了坚实的基础。

一、开源框架的兴起与生态构建

2016年,开源人工智能框架呈现出百花齐放的态势。Google发布的TensorFlow 1.0版本正式推出,凭借其灵活的架构、强大的分布式计算支持以及丰富的工具链,迅速成为工业界和学术界最受欢迎的深度学习框架之一。与此Facebook主导的PyTorch虽然尚未正式发布1.0版本,但其动态计算图的特性吸引了大量研究人员的关注,为后续的快速发展埋下伏笔。微软也通过CNTK框架展示了其在深度学习基础设施上的实力。这些开源框架的竞争与合作,极大地降低了AI开发的门槛,促进了全球开发者的协作与创新。

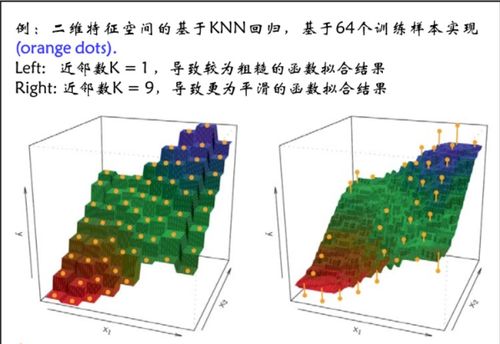

二、算法与模型库的丰富化

在基础软件层面,2016年见证了众多经典算法的实现与优化。以计算机视觉为例,ResNet、Inception-v3等模型通过开源框架得以广泛传播与应用。自然语言处理领域,Word2Vec、GloVe等词向量技术成为标准配置,而基于LSTM和GRU的序列模型在各类任务中表现出色。强化学习库如OpenAI Gym的发布,为算法测试与比较提供了标准化环境,推动了深度强化学习研究的快速发展。

三、开发工具链的完善

为了提高开发效率,2016年AI基础软件开发工具链得到了显著加强。可视化工具如TensorBoard的出现,使得研究人员能够直观地监控训练过程、分析模型结构。自动化超参数调优工具开始萌芽,尽管尚未成熟,但已显示出减少人工干预的潜力。模型部署工具也逐渐受到重视,例如TensorFlow Serving的推出,帮助开发者将训练好的模型高效地部署到生产环境中。

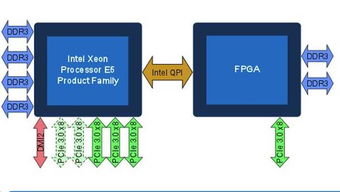

四、硬件与软件的协同优化

随着GPU在深度学习训练中的普及,2016年的基础软件开发更加注重与硬件的协同优化。CUDA深度神经网络库(cuDNN)不断更新,提供了高度优化的底层原语,大幅提升了训练速度。各大框架也加强了对多GPU并行训练的支持,使得处理更大规模数据集和更复杂模型成为可能。针对嵌入式设备和移动端的轻量级推理框架开始崭露头角,为AI技术的端侧部署铺平道路。

五、社区与教育资源的蓬勃发展

2016年,围绕AI基础软件开发的社区生态迅速壮大。GitHub上相关项目的星标数快速增长,在线论坛和社交媒体上的讨论日益活跃。众多高质量的教程、在线课程和技术博客涌现,帮助新手快速入门。高校与研究机构也纷纷开设相关课程,将最新的工具与实践引入课堂。这种知识共享的氛围,加速了AI技术的传播与创新。

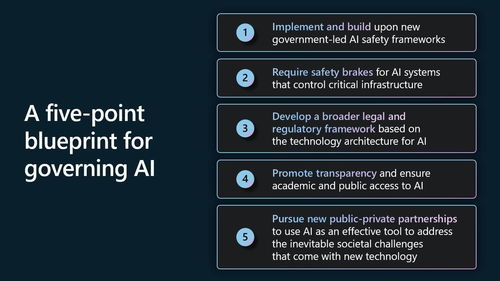

六、挑战与展望

尽管成就斐然,2016年的AI基础软件开发仍面临一些挑战。不同框架之间的兼容性问题、模型的可复现性、大规模分布式训练的稳定性等,都是亟待解决的难题。如何让软件更好地适应多样化的硬件环境,如何提高开发调试的效率,也需要持续探索。

2016年的进展为AI基础软件的发展指明了方向:更加易用的接口、更强大的性能、更完善的生态。这些努力不仅推动了人工智能技术的民主化,也为后续在自动驾驶、医疗诊断、智能助理等领域的应用突破提供了坚实支撑。

2016年是人工智能基础软件开发承前启后的关键一年。通过开源协作、工具创新与生态建设,开发者社区共同构建了更加繁荣的技术 landscape,为人工智能的黄金时代拉开了序幕。